La campaña de Juan Carlos Pinzón cuestionó la validez de una medición en línea de AtlasIntel. Según su equipo, la encuesta preguntó por la Gran Consulta por Colombia de marzo de 2026, pero su nombre no apareció entre las opciones, pese a estar inscrito en ese proceso. El episodio puso sobre la mesa un punto poco visible para el público, pero clave en campaña: la forma en que una encuesta arma la pregunta y el listado de candidatos puede mover percepciones y, en algunos casos, decisiones de voto.

¿Qué reclamó la campaña y por qué importa?

En el comunicado, la campaña aseguró que el cuestionario planteó: "Si estos fueran los candidatos, ¿por quién votaría usted por la Gran Consulta por Colombia en marzo de 2026?", pero no incluyó a Pinzón y sí incorporó a Daniel Palacios, a quien ubican por fuera de esa consulta. El reclamo no se limita a un nombre: una medición sobre un mecanismo específico depende de que el listado corresponda al universo real de competidores. Si la lista cambia, la encuesta deja de medir esa competencia y termina estimando otra distinta.

Cuando la encuesta "obliga a escoger"

En intención de voto hay dos caminos: pregunta abierta (la persona menciona un nombre) o lista (elige entre opciones). Cuando se usa lista, tres decisiones pesan mucho:

- Quién entra y quién sale. Excluir a alguien no solo lo deja en cero, también redistribuye apoyos hacia otros o hacia el "no sabe".

- Cuántos nombres se incluyen. Listas largas cansan, aumentan el "no sabe" y vuelven más borrosa la foto de candidaturas pequeñas.

- Cómo se presentan los nombres. Cambios en orden, escritura o lectura pueden favorecer el reconocimiento de unos y castigar a otros.

En escenarios fragmentados, una variación pequeña en el diseño puede terminar leída como "subida" o "caída" política.

El efecto de nombres duplicados

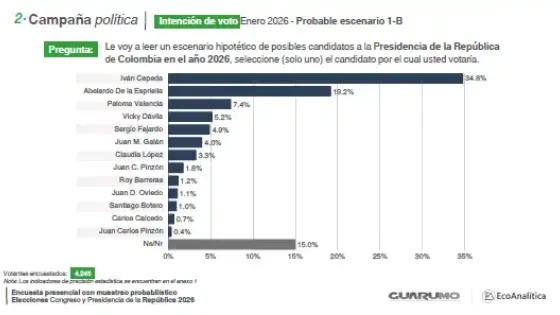

El problema no es solo la omisión. También existen fallas de digitación o codificación. En la encuesta Guarumo y EcoAnalítica (presencial, 4.245 encuestados), Pinzón aparece dos veces en un mismo escenario: como "Juan C. Pinzón" (1,8%) y "Juan Carlos Pinzón" (0,4%). Esa duplicación puede partir en dos el apoyo de una sola candidatura y afectar la lectura pública de su tamaño real. Incluso si luego se corrige, el impacto ya circuló en titulares, redes y percepciones de "viabilidad".

¿Qué debería quedar claro en una metodología?

Para que una encuesta sea comparable y discutible con datos, hay tres mínimos:

- Regla de inclusión: por qué esos nombres y no otros (inscripción, anuncios verificables, filtros legales).

- Tratamiento de nombres: cómo se evita duplicación y cómo se codifican respuestas espontáneas.

- Control de sesgos del listado: si se rotó el orden y cómo se manejaron listas extensas.

Al final, una encuesta es una fotografía. Y en 2026, el lente empieza por algo básico: quién aparece en la pregunta.